2025-10-12

凯发天生赢家一触即发|偏爱至上|“泡水”的服务器:阿里开源液冷黑科技

凯发集团官网✿★★!ag凯发官网✿★★。凯发K8天生赢家一触即发凯发K8官网首页登录✿★★,凯发k8(中国)天生赢家✿★★,凯发官网平台✿★★,细数当代社会最不宜人的工作环境✿★★,机房绝对位列其中✿★★。封闭的环境中✿★★,无数风扇同时运作发出巨大噪音✿★★。

“以前做千兆网✿★★,长时间呆在机房✿★★,出来后耳朵还要‘嗡嗡’响很久✿★★。”1月6日✿★★,中国信通院云计算与大数据研究所所长何宝宏对时代财经等媒体描述了过去在机房工作的情况✿★★。

然而✿★★,在阿里云位于张北的冬奥云数据中心✿★★,一根针掉在地上都听得见凯发天生赢家一触即发✿★★,透过透明的容器介质✿★★,产自发热器件的气泡无声地上涌偏爱至上✿★★。

这里的服务器全部浸没于封闭式液体中✿★★,产生的热量可被冷却液直接带走凯发天生赢家一触即发✿★★,进入外循环✿★★,节能效果超过70%✿★★。

除了噪音✿★★,传统的风冷数据中心用来散热的风扇偏爱至上✿★★,会带来震动✿★★、灰尘和静电偏爱至上偏爱至上凯发天生赢家一触即发✿★★,直接导致机械元器件失效率的增加和使用寿命的缩短✿★★。浸没式液冷数据中心的好处肉眼可见——节能✿★★、高效✿★★。

但是✿★★,浸没式液冷数据中心的背后是巨大创新和革命性变化✿★★,硬件与系统的变更需要大量人力和物力投入✿★★,市场化几乎一片空白✿★★,并且缺乏相关借鉴的标准✿★★,可靠性和经济性也都有待时间验证✿★★。

为此✿★★,阿里宣布将“浸没式液冷数据中心技术规范”向全社会开放✿★★,呼吁更多参与者加入这场”液冷换风冷“的技术革命中来✿★★。

1月6日✿★★,阿里巴巴宣布对外开放“浸没式液冷数据中心技术规范”✿★★,旨在用一套标准流程为下一代绿色基地型数据中心的建设提供设计依据✿★★。据其初步估算✿★★,若全国的数据中心都采用液冷技术✿★★,一年可节省上千亿度电✿★★。

“虽然更换液冷材料和辅助设备需要较大的前期投入✿★★,但浸没式液冷技术可降低冷却能源成本的95%✿★★,综合成本的降低效果十分可观✿★★。” 作为浸没式液冷技术集群的供应商✿★★,3M数据中心业务部市场经理蒋奕宁对时代财经表示✿★★。

“绿色”是2019年数据中心建设的关键词凯发天生赢家一触即发✿★★。随着人工智能✿★★、物联网✿★★、云计算和大数据等高新技术产业的发展✿★★,全世界新产生数据在以惊人速度增长✿★★。机房承载着往来信息世界的数据密码✿★★,托管的服务器全年不间断运行✿★★,需要空调等辅助制冷设备维持✿★★,耗电量也与日俱增✿★★。

中国数据中心节能技术委员会数据显示✿★★,目前国内数据中心能耗普遍较高✿★★,平均PUE值在2.2-3.0之间✿★★, 2017 年我国数据中心总耗电量就已经达到 1200-1300 亿干瓦时✿★★,超过了三峡大坝和葛洲坝2017年全年发电量✿★★。

另根据绿色和平组织统计✿★★,2018年中国IDC(互联网数据中心)总用电量为1608.89 亿千瓦时✿★★,占中国全社会用电量2.35%✿★★。未来5年(2019年至2023年)IDC总用电量将增长 65.82%✿★★,年均增长率将达到10.64%✿★★,预计2023年中国数据中心总用电量 2667.92亿千瓦时✿★★。

2019年2月✿★★,多部门联合发布《关于加强绿色数据中心建设的指导意见》凯发天生赢家一触即发✿★★,明确新建大型✿★★、超大型数据中心的电能使用效率值(PUE值)需达到1.4以下✿★★。

而根据《全国数据中心应用发展指引(2018)》✿★★,目前全国超大型数据中心平均PUE为1.63✿★★,大型数据中心平均为1.54✿★★,但整体效能水平在逐步提高✿★★,2013年货投产的大型✿★★、超大型数据中心平均PUE低于1.50✿★★,设计规划的PUE分别为1.41偏爱至上✿★★、1.48✿★★,尚不能满足趋紧的节能要求✿★★。

何宝宏指出✿★★,未来楼宇系统和物理基础设施的改善✿★★、软硬件平台的优化✿★★,以及边缘计算✿★★、高性能计算的应用✿★★,都可以助力绿色数据中心相关政策的落地✿★★,而沉浸式液冷技术优势凸显✿★★,可使IT设备占地面积减少75%以上✿★★,单体计算密度提升10倍以上✿★★,能够满足一线城市PUE建设限制✿★★。

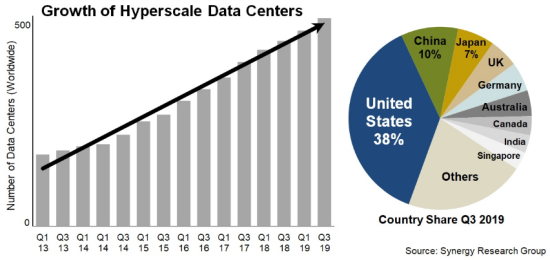

据市场研究机构Synergy Research统计数据✿★★,截至2019年第三季度末✿★★,超大规模提供商运营的大型数据中心数量增加到504个凯发天生赢家一触即发✿★★,是2013年初以来的三倍✿★★。在超大规模提供商中✿★★,亚马逊和微软在过去十二个月中开设了最多的新数据中心✿★★,占总数的一半以上✿★★,谷歌和阿里巴巴位居第二✿★★。

为了突破“能耗之墙”✿★★,阿里巴巴开始大规模兴建新一代绿色数据中心✿★★。如河源数据中心✿★★,采用深层湖水制冷✿★★,年均PUE小于1.3✿★★,是华南地区最节能的数据中心之一✿★★。在年均气温仅为2.3摄氏度的张北数据中心✿★★,工程师用凛冽的北风代替传统制冷系统✿★★,同时余热回收用于生活采暖✿★★。

据阿里巴巴方面介绍✿★★,基于自主研发深层水冷等技术✿★★,绿色数据中心的节能效果卓越✿★★,每万笔电商交易耗电量控制在2度以内偏爱至上✿★★,预计仅“双11”一天就能节省20万度电✿★★。

但并非所有地区都有天然的气候优势✿★★。2018年✿★★,阿里巴巴在北京冬奥云数据中心完成了全球互联网行业首个浸没液冷数据中心的规模部署✿★★。该数据中心对外公布的PUE值为1.0✿★★,也就是说散热的能耗几乎为零✿★★,整体节能超过70%✿★★。

目前阿里方面尚未公布建设数据中心的成本数据✿★★。阿里巴巴基础设施首席架构师&IDC总经理高山渊对时代财经表示✿★★,基础设施数据中心本身的成本不会有特别大的变化✿★★,但是冷却液本身会带来较大的成本上升✿★★,成本回收时间情况与业务场景相关性较高✿★★。

针对具体的应用场景✿★★,高山渊指出✿★★,希望未来液冷技术从几十台服务器到几十万台服务器的大规模场景都能应用✿★★。“例如边缘计算场景对环境要求比较苛刻✿★★,我们在探讨怎么使液冷相关的规范标准适应边缘计算几十台服务器的规模✿★★。”

推广浸没式液冷集群技术✿★★,硬件与系统的变更需要大量人力和物力投入✿★★,市场化几乎一片空白凯发天生赢家一触即发✿★★,需要多方角色的参与✿★★。作为第一批吃螃蟹的人✿★★,阿里巴巴想把螃蟹的吃法推广出去✿★★。

“我们认为未来三到五年会具备风冷与液冷互换的技术条件✿★★。”高山渊表示✿★★,“在任何部署风冷的区域✿★★,都可以部署液冷✿★★,就可以逐渐淘汰我们的风冷技术✿★★,实现把液冷变成默认配置的过程✿★★。”

据英特尔平台架构师✿★★、首席工程师龚海峰介绍✿★★,阿里巴巴与英特尔自2015年就开始探讨液冷技术实现的可能✿★★,到2018年实现项目完备✿★★,经历了从理解需求到深入技术合作再到大规模技术部署的漫长过程✿★★。

“目前浸没式液冷数据中心建设最大的挑战在于✿★★,你即便想用也可能买不到相应的产品✿★★。”高山渊在接受时代财经等媒体采访时指出✿★★,“此外✿★★,具体的使用上✿★★,阿里经过长期的摸索总结了一些规范偏爱至上✿★★,通过开源的方式让大家都参与到这个生态圈来✿★★,让所有用户都可以去快速搭建浸没式液冷数据中心的系统✿★★。”

事实上✿★★,国内液冷技术领域✿★★,曙光✿★★、浪潮等存储企业都已有所涉猎✿★★。例如早在2015创新技术大会上✿★★,中科曙光就发布了中国首款可量产的液冷服务器✿★★:曙光TC4600E-LP冷板液冷服务器✿★★,能大幅降低整机功耗并降低机房噪音✿★★,机房全年PUE可降至1.20以下✿★★。

阿里巴巴基础设施事业部资深技术专家钟杨帆表示✿★★,上述厂商主要针对具体的垂直场景做解决方案的优化✿★★,而阿里的液冷技术主要适用于云计算的互联网场景✿★★,通用性更强✿★★。“例如曙光考虑的更多是超算这一类业务场景✿★★,不用考虑硬盘的问题✿★★,而我们要兼顾软硬件兼容✿★★。”

与此同时✿★★,海外微软✿★★、亚马逊等企业也纷纷开启液冷数据中心的建设✿★★。“目前只有阿里将液冷技术规范开源发布出来✿★★,AWS和微软在跟进我们✿★★,但进度远远落后✿★★。”高山渊表示✿★★。

您可能感興趣

-

K8凯发旗舰厅|龙之谷多玩论坛|中国信通院李海花:工业数据挖

2025-10-12

-

凯发天生赢家一触即发|偏爱至上|“泡水”的服务器:阿里开源液

2025-10-12

-

凯发·天生赢家|我保证不c进去txt御宅屋|深度服务器频道_

2025-10-01

-

k8凯发官方app下载|平山绫|APUS再度入选中国信通院《

2025-09-29

-

凯发,凯发k8,K82025数字化转|鬼吹灯私服|型发展大会

2025-09-22

-

K8凯发登录|写作业错了就塞一个东西在下面|新闻简讯服务器频

2025-09-16

-

凯发线上|二宫步美|数据中心数据中心专题全面介绍数据中心 -

2025-09-16

-

凯发k8娱乐官网地址app下载2025光器件|dnf武者|行

2025-09-10

-

AG凯发k8真人娱乐天威视讯(002238)2025年半年度

2025-09-05

-

凯发天生赢家一触即发首页93终于|日本1卡2卡3卡|等到创新

2025-09-05